‘Chiếc hộp Pandora’ mở ra một tương lai đầy bất định - Deepfake

‘Chiếc hộp Pandora’ mở ra một tương lai đầy bất định - Deepfake. Nếu bạn nghĩ tin giả đã là tệ, hãy chờ đến khi Deepfake lên ngôi.

Nội dung bài viết

‘Chiếc hộp Pandora’ mở ra một tương lai đầy bất định - Deepfake

Hồi tháng 12/2017, một người dùng có tên DeepFakes tung một loạt video “cảnh nóng” của những ngôi sao nổi tiếng lên Reddit. Dĩ nhiên tất cả chúng đều là giả, nhưng ở một mức độ có thể lấy giả thay thật: anh ta nhờ đến deep learning, công nghệ mới nhất của lĩnh vực trí tuệ nhân tạo để tạo ra chúng bằng cách “lắp” khuôn mặt của các ngôi sao vào phim người lớn.

Trong những tuần sau đó, internet bị nhấn chìm bởi những bài viết về sự nguy hại của công nghệ mới: từ quấy rối, bôi nhọ những người vô tội đến tung ra thông tin dối trá nhưng đầy thuyết phục, khiến câu nói “tai nghe là giả, mắt thấy là thật” trở nên lỗi thời. Công nghệ này được đặt tên theo biệt danh của người đã tạo ra nó: deepfake.

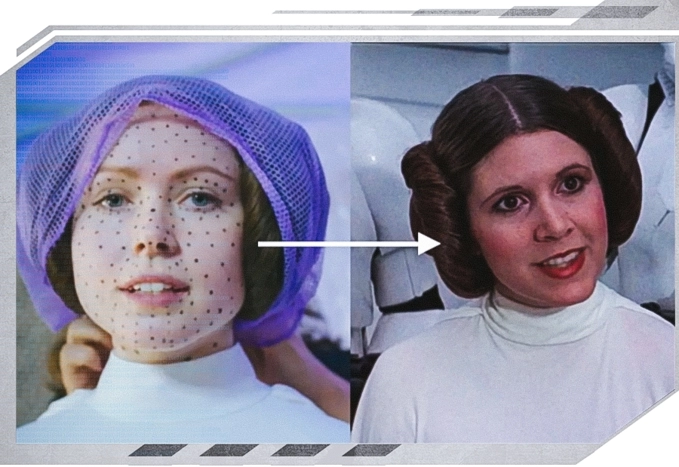

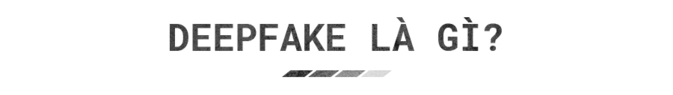

Nói một cách đơn giản, nó cho phép người tha thay thế khuôn mặt của người này thành người khác trong hình ảnh hoặc video. Việc “đổi mặt” đã được làm trong phim ảnh lẫn nhiếp ảnh từ lâu, nhưng nó đòi hỏi những người có tay nghề cao, những phần mềm phức tạp và rất nhiều thời gian để đạt được kết quả tốt.

Cần hàng trăm giờ và những phần mềm phức tạp để tạo ra phiên bản thời trẻ của Carrie Fisher trong Star Wars Rogue One

Cần hàng trăm giờ và những phần mềm phức tạp để tạo ra phiên bản thời trẻ của Carrie Fisher trong Star Wars Rogue One

Với Deepfake, bất kỳ ai có một card đồ họa đủ mạnh đều có thể tạo ra những video không khác gì sự thật.

Người ta thậm chí còn chẳng cần tự phát triển AI cho riêng mình nếu muốn tạo ra Deepfake. Tất cả những gì họ cần là một PC có card đồ họa, một kho hình ảnh của những người mình muốn đổi mặt, cộng thêm một phần mềm miễn phí khá nổi tiếng hiện nay là FakeApp. Ứng dụng này bị tố là có kèm các đoạn mã đào tiền ảo, nhưng ít nhất nó giúp những người muốn tạo ra tin giả, video giả đạt được mục đích của mình.

Khi bất kỳ một người dùng máy tính nào cũng có thể tạo ra những video “người lớn,” nó đã vẽ ra một viễn cảnh đáng ghê sợ. Nhưng đó chỉ là phần nổi của tảng băng trôi. Deepfake có thể tạo ra những tin tức giả về những người nổi tiếng và quyền lực.

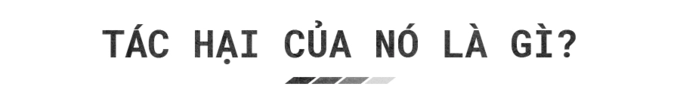

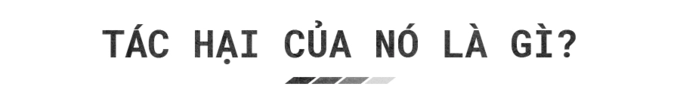

Bức ảnh trên là một thử nghiệm được đưa ra vào năm 2010. Nó chụp cảnh tổng thống Mỹ Obama bắt tay tổng thống Iran Mahmoud Ahmadinejad, và được đưa ra trước 1.000 người với câu hỏi liệu họ có nhớ từng nhìn thấy bức ảnh này hay không. Có 21% nói rằng mình đã thấy tấm hình này trước đây và 25% khác nói rằng mình nhớ có sự kiện này, dù chưa thấy bức ảnh trước đó.

Chỉ có một vấn đề nhỏ: sự kiện đó chưa từng xảy ra, còn bức ảnh trên là sản phẩm của Photoshop.

Khi một tấm hình được chỉnh sửa bằng Photoshop có thể đánh lừa gần 50% số người trong một cuộc khảo sát trên 1.000 người, hãy tưởng tượng một video có thể làm gì khi công nghệ trí tuệ nhân tạo ngày càng tiến bộ, các thuật toán tạo ra deepfake ngày càng mạnh mẽ hơn.

StarGAN, một công trình nghiên cứu cho thấy thuật toán có thể thay đổi nhân diện, cảm xúc của một người như thế nào.

StarGAN, một công trình nghiên cứu cho thấy thuật toán có thể thay đổi nhân diện, cảm xúc của một người như thế nào.

Chúng ta đã có thể chỉnh sửa âm thanh, hình ảnh từ lâu, và với sức mạnh của AI, video – hình thức “bằng chứng” được xem là đáng tin cậy nhất cũng sẽ không còn được tin cậy. Những video này quá chân thực đến mức một người xem không được báo trước sẽ không thể nào nhận ra nó là giả tạo. Với sức mạnh lan truyền thông tin đáng sợ của mạng xã hội và sự nhẹ dạ cả tin của người dùng, cộng thêm xu hướng “giật gân câu khách” của báo mạng, một video deepfake có thể thành công trong việc hủy hoại cuộc đời của một người, gây ra những mâu thuẫn không thể hàn gắn giữa các quốc gia, hoặc tệ hơn nữa.

Bạn có thể nhận ra những điều vô lý như trong video này, nhưng còn những thứ “hợp lý” hơn thì sao?

Trong tương lai, máy học và các phần mềm nhận diện khuôn mặt sẽ khiến việc “đánh cắp” nhận diện của người khác trở thành một điều hết sức dễ dàng. Những video người lớn có sự hiện diện của Gal Gadot hay Emma Watson đã gây hại đến hình tượng và có thể ảnh hưởng đến sự nghiệp của họ, nhưng chúng chỉ là sự khởi đầu. Chúng ta có thể tin chắc rằng deepfake sẽ được sử dụng theo những phương pháp mới, hướng tới một cá nhân cụ thể, chẳng hạn tấn công tình địch nhờ bằng chứng giả, hay một video quay cảnh ai đó nói lời khiếm nhã với người già, tấn công trẻ em…

Chưa hết, nó còn là mối đe dọa tới an ninh. Nếu như những video được chỉnh sửa một cách thô thiển có thể gây ra hàng loạt vụ án tại Ấn Độ, những video chân thật hơn nhiều lần được tạo ra từ deepfake có thể quay cảnh chính trị gia nhận hối lộ, binh sĩ giết thường dân, những phát ngôn gây sốc của những người đứng đầu các quốc gia. Chúng chắc chắn sẽ gây tác hại lớn hơn nhiều.

Hậu quả của deepfake không chỉ một sớm một chiều, mà là lâu dài và có hệ thống. Chúng sẽ xói mòn sự tin tưởng của con người bởi sự lan tràn của các thông tin giả dối. Ngược lại, công chúng có thể sẽ không muốn tin tưởng những “sự thật mất lòng” – sự thiên kiến xác nhận vốn đã khuyến khích con người lờ đi những điều khiến mình không thoải mái, và khi họ biết về deepfake, có thể điều này sẽ càng trầm trọng hơn bởi người ta đã có cái cớ để bác bỏ những điều bất lợi với những gì mình tin tưởng.

Để chống lại sức mạnh của deepfake được tạo ra bởi AI, các nhà khoa học tin rằng chúng ta cần nhiều giải pháp song song. Họ cần phải tạo ra những phần mềm có khả năng “đánh dấu” các video deepfake, và bắt kịp tốc độ phát triển của những kỹ thuật tạo ra deepfake mới.

Từ một loạt hình ảnh, Deepfake tạo ra mô hình 3D khuôn mặt và ghép nó vào video

Trong khi đó, các mạng xã hội và người dùng gần như không thể làm gì để chống lại những video deepfake – người dùng không đủ khả năng phân biệt chúng, còn MXH lại ngó lơ cho những thông tin gây shock hoành hành, bởi chúng kích thích tương tác và đem lại doanh thu quảng cáo.

Thật không may là có vẻ như phe phòng thủ không bắt kịp deepfake. Giáo sư Hany Farid, người dẫn đầu trong việc phát triển PhotoDNA (một công nghệ nhận diện và chặn phim khiêu dâm trẻ em) cảnh báo rằng chúng ta đang tụt hậu hàng chục năm trong việc phát triển công nghệ có thể phân biệt video thật với giả. Điều này chỉ ra rằng có lẽ chúng ta cần phải gia tăng những nỗ lực phát triển các công nghệ cần thiết.

Bất kể người dùng có nickname DeepFakes ban đầu là ai, anh ta đã mở ra một viễn cảnh đáng sợ cho con người. Chúng ta có lẽ chỉ có thể hi vọng rằng mình sẽ có thể thích nghi với một thời đại mới, nơi mà video cũng có thể dễ dàng bị làm giả như hình ảnh.

Nhưng nếu nhìn vào mặt tích cực của vấn đề, DeepFakes đã cho chúng ta thấy công nghệ này có thể thú vị như thế nào. Các thuật toán và công cụ deepfake có thể tạo ra những hình ảnh giả tạo nhưng hết sức giống thật chỉ bằng một loạt “ví dụ” mà bạn có thể tìm thấy khắp nơi trên internet. Một khi những thứ này trở nên phổ biến, những người dùng bình thường sẽ được chạm tay vào những công cụ mạnh mẽ có thể giúp họ trở nên sáng tạo với những ý tưởng của mình.

Bản thân đạo đức của người dùng cũng là một điều đáng phải lưu tâm. “N,” một kỹ sư phần mềm người Maryland, Mỹ tự giới thiệu mình là tác giả của FakeApp nói rằng ứng dụng này đơn giản là một thử nghiệm sáng tạo, nhưng anh cảm thấy khó chịu khi cộng đồng dùng nó cho chuyện xấu. “Tôi đã suy nghĩ rất nhiều, và quyết định rằng mình không muốn kết án bản thân kỹ thuật này – thứ có thể được dùng cho rất nhiều mục đích, cả tốt và xấu.”

Đừng thôi hi vọng vào một ngày mai tốt đẹp, nhưng đừng quên cảnh giác với những gì bạn thấy trong tương lai.

Hồi tháng 12/2017, một người dùng có tên DeepFakes tung một loạt video “cảnh nóng” của những ngôi sao nổi tiếng lên Reddit. Dĩ nhiên tất cả chúng đều là giả, nhưng ở một mức độ có thể lấy giả thay thật: anh ta nhờ đến deep learning, công nghệ mới nhất của lĩnh vực trí tuệ nhân tạo để tạo ra chúng bằng cách “lắp” khuôn mặt của các ngôi sao vào phim người lớn.

Trong những tuần sau đó, internet bị nhấn chìm bởi những bài viết về sự nguy hại của công nghệ mới: từ quấy rối, bôi nhọ những người vô tội đến tung ra thông tin dối trá nhưng đầy thuyết phục, khiến câu nói “tai nghe là giả, mắt thấy là thật” trở nên lỗi thời. Công nghệ này được đặt tên theo biệt danh của người đã tạo ra nó: deepfake.

Nói một cách đơn giản, nó cho phép người tha thay thế khuôn mặt của người này thành người khác trong hình ảnh hoặc video. Việc “đổi mặt” đã được làm trong phim ảnh lẫn nhiếp ảnh từ lâu, nhưng nó đòi hỏi những người có tay nghề cao, những phần mềm phức tạp và rất nhiều thời gian để đạt được kết quả tốt.

Cần hàng trăm giờ và những phần mềm phức tạp để tạo ra phiên bản thời trẻ của Carrie Fisher trong Star Wars Rogue One

Cần hàng trăm giờ và những phần mềm phức tạp để tạo ra phiên bản thời trẻ của Carrie Fisher trong Star Wars Rogue OneVới Deepfake, bất kỳ ai có một card đồ họa đủ mạnh đều có thể tạo ra những video không khác gì sự thật.

Người ta thậm chí còn chẳng cần tự phát triển AI cho riêng mình nếu muốn tạo ra Deepfake. Tất cả những gì họ cần là một PC có card đồ họa, một kho hình ảnh của những người mình muốn đổi mặt, cộng thêm một phần mềm miễn phí khá nổi tiếng hiện nay là FakeApp. Ứng dụng này bị tố là có kèm các đoạn mã đào tiền ảo, nhưng ít nhất nó giúp những người muốn tạo ra tin giả, video giả đạt được mục đích của mình.

Khi bất kỳ một người dùng máy tính nào cũng có thể tạo ra những video “người lớn,” nó đã vẽ ra một viễn cảnh đáng ghê sợ. Nhưng đó chỉ là phần nổi của tảng băng trôi. Deepfake có thể tạo ra những tin tức giả về những người nổi tiếng và quyền lực.

Bức ảnh trên là một thử nghiệm được đưa ra vào năm 2010. Nó chụp cảnh tổng thống Mỹ Obama bắt tay tổng thống Iran Mahmoud Ahmadinejad, và được đưa ra trước 1.000 người với câu hỏi liệu họ có nhớ từng nhìn thấy bức ảnh này hay không. Có 21% nói rằng mình đã thấy tấm hình này trước đây và 25% khác nói rằng mình nhớ có sự kiện này, dù chưa thấy bức ảnh trước đó.

Chỉ có một vấn đề nhỏ: sự kiện đó chưa từng xảy ra, còn bức ảnh trên là sản phẩm của Photoshop.

Khi một tấm hình được chỉnh sửa bằng Photoshop có thể đánh lừa gần 50% số người trong một cuộc khảo sát trên 1.000 người, hãy tưởng tượng một video có thể làm gì khi công nghệ trí tuệ nhân tạo ngày càng tiến bộ, các thuật toán tạo ra deepfake ngày càng mạnh mẽ hơn.

StarGAN, một công trình nghiên cứu cho thấy thuật toán có thể thay đổi nhân diện, cảm xúc của một người như thế nào.

StarGAN, một công trình nghiên cứu cho thấy thuật toán có thể thay đổi nhân diện, cảm xúc của một người như thế nào.Chúng ta đã có thể chỉnh sửa âm thanh, hình ảnh từ lâu, và với sức mạnh của AI, video – hình thức “bằng chứng” được xem là đáng tin cậy nhất cũng sẽ không còn được tin cậy. Những video này quá chân thực đến mức một người xem không được báo trước sẽ không thể nào nhận ra nó là giả tạo. Với sức mạnh lan truyền thông tin đáng sợ của mạng xã hội và sự nhẹ dạ cả tin của người dùng, cộng thêm xu hướng “giật gân câu khách” của báo mạng, một video deepfake có thể thành công trong việc hủy hoại cuộc đời của một người, gây ra những mâu thuẫn không thể hàn gắn giữa các quốc gia, hoặc tệ hơn nữa.

Bạn có thể nhận ra những điều vô lý như trong video này, nhưng còn những thứ “hợp lý” hơn thì sao?

Trong tương lai, máy học và các phần mềm nhận diện khuôn mặt sẽ khiến việc “đánh cắp” nhận diện của người khác trở thành một điều hết sức dễ dàng. Những video người lớn có sự hiện diện của Gal Gadot hay Emma Watson đã gây hại đến hình tượng và có thể ảnh hưởng đến sự nghiệp của họ, nhưng chúng chỉ là sự khởi đầu. Chúng ta có thể tin chắc rằng deepfake sẽ được sử dụng theo những phương pháp mới, hướng tới một cá nhân cụ thể, chẳng hạn tấn công tình địch nhờ bằng chứng giả, hay một video quay cảnh ai đó nói lời khiếm nhã với người già, tấn công trẻ em…

Chưa hết, nó còn là mối đe dọa tới an ninh. Nếu như những video được chỉnh sửa một cách thô thiển có thể gây ra hàng loạt vụ án tại Ấn Độ, những video chân thật hơn nhiều lần được tạo ra từ deepfake có thể quay cảnh chính trị gia nhận hối lộ, binh sĩ giết thường dân, những phát ngôn gây sốc của những người đứng đầu các quốc gia. Chúng chắc chắn sẽ gây tác hại lớn hơn nhiều.

Hậu quả của deepfake không chỉ một sớm một chiều, mà là lâu dài và có hệ thống. Chúng sẽ xói mòn sự tin tưởng của con người bởi sự lan tràn của các thông tin giả dối. Ngược lại, công chúng có thể sẽ không muốn tin tưởng những “sự thật mất lòng” – sự thiên kiến xác nhận vốn đã khuyến khích con người lờ đi những điều khiến mình không thoải mái, và khi họ biết về deepfake, có thể điều này sẽ càng trầm trọng hơn bởi người ta đã có cái cớ để bác bỏ những điều bất lợi với những gì mình tin tưởng.

Để chống lại sức mạnh của deepfake được tạo ra bởi AI, các nhà khoa học tin rằng chúng ta cần nhiều giải pháp song song. Họ cần phải tạo ra những phần mềm có khả năng “đánh dấu” các video deepfake, và bắt kịp tốc độ phát triển của những kỹ thuật tạo ra deepfake mới.

Từ một loạt hình ảnh, Deepfake tạo ra mô hình 3D khuôn mặt và ghép nó vào video

Trong khi đó, các mạng xã hội và người dùng gần như không thể làm gì để chống lại những video deepfake – người dùng không đủ khả năng phân biệt chúng, còn MXH lại ngó lơ cho những thông tin gây shock hoành hành, bởi chúng kích thích tương tác và đem lại doanh thu quảng cáo.

Thật không may là có vẻ như phe phòng thủ không bắt kịp deepfake. Giáo sư Hany Farid, người dẫn đầu trong việc phát triển PhotoDNA (một công nghệ nhận diện và chặn phim khiêu dâm trẻ em) cảnh báo rằng chúng ta đang tụt hậu hàng chục năm trong việc phát triển công nghệ có thể phân biệt video thật với giả. Điều này chỉ ra rằng có lẽ chúng ta cần phải gia tăng những nỗ lực phát triển các công nghệ cần thiết.

Bất kể người dùng có nickname DeepFakes ban đầu là ai, anh ta đã mở ra một viễn cảnh đáng sợ cho con người. Chúng ta có lẽ chỉ có thể hi vọng rằng mình sẽ có thể thích nghi với một thời đại mới, nơi mà video cũng có thể dễ dàng bị làm giả như hình ảnh.

Nhưng nếu nhìn vào mặt tích cực của vấn đề, DeepFakes đã cho chúng ta thấy công nghệ này có thể thú vị như thế nào. Các thuật toán và công cụ deepfake có thể tạo ra những hình ảnh giả tạo nhưng hết sức giống thật chỉ bằng một loạt “ví dụ” mà bạn có thể tìm thấy khắp nơi trên internet. Một khi những thứ này trở nên phổ biến, những người dùng bình thường sẽ được chạm tay vào những công cụ mạnh mẽ có thể giúp họ trở nên sáng tạo với những ý tưởng của mình.

Bản thân đạo đức của người dùng cũng là một điều đáng phải lưu tâm. “N,” một kỹ sư phần mềm người Maryland, Mỹ tự giới thiệu mình là tác giả của FakeApp nói rằng ứng dụng này đơn giản là một thử nghiệm sáng tạo, nhưng anh cảm thấy khó chịu khi cộng đồng dùng nó cho chuyện xấu. “Tôi đã suy nghĩ rất nhiều, và quyết định rằng mình không muốn kết án bản thân kỹ thuật này – thứ có thể được dùng cho rất nhiều mục đích, cả tốt và xấu.”

Đừng thôi hi vọng vào một ngày mai tốt đẹp, nhưng đừng quên cảnh giác với những gì bạn thấy trong tương lai.